I. Introducción: El error humano como fuente de la responsabilidad.

La inteligencia artificial generativa, con herramientas como ChatGPT, Gemini o Copilot, ha irrumpido en el ámbito legal siendo utilizada por los abogados para mejorar la redacción de sus documentos, la investigación y el análisis de sus casos. Si bien esto suena interesante, su rápida adopción no ha estado exenta de riesgos.

Tanto la jurisprudencia nacional como internacional han detectado y remarcado la incorrecta utilización de estas herramientas. La presentación de escritos que contenían información errónea y jurisprudencia inexistente por alucinaciones de la inteligencia artificial se ha traducido en los Juzgados en llamados de atención por falta de ética profesional, notificaciones a los Colegios de Abogados, multas a los letrados y pérdida de litigios.

Ante el aumento de estos casos, en este artículo no pretendo analizar cada uno en particular. Más bien, buscaré trazar un paralelismo que puede resultar de utilidad y profundizar en un principio conocido en el mundo de la ciberseguridad, el cual considero una herramienta fundamental para concientizar sobre el correcto uso de la inteligencia artificial en la Justicia. De esta manera, se podrá mitigar uno de los principales problemas que enfrenta hoy la relación entre el Derecho y la tecnología: la negligencia de los abogados que utilizan inteligencia artificial para fundamentar sus escritos sin verificar los outputs obtenidos.

En definitiva, los riesgos derivados del uso de la inteligencia artificial no son tecnológicos, sino humanos: la herramienta no se equivoca por sí misma, sino cuando el profesional la utiliza sin el debido control ni criterio jurídico. La responsabilidad, por tanto, no radica en el sistema, sino en la persona que confía ciegamente en él.

En este artículo analizaré cómo el principio 'Don't Trust, Verify' (no confíes, verifica) se relaciona con el Derecho, y por qué debe ser adoptado en la vida digital de los abogados y el personal de Justicia.

II. Jurisprudencia: De la confianza ciega al error humano.

Con base en la jurisprudencia existente, dejaré evidenciado cómo el error humano de no verificar lo que la IA arroja se hizo presente en cada caso. En mi opinión, y adelantando algunas conclusiones, en esta etapa inicial de la integración de la inteligencia artificial al Derecho, resulta esencial reforzar la educación tecnológica de los operadores jurídicos. Muchos profesionales, por su formación, edad o cualquier otra razón, carecen del dominio adecuado de las herramientas digitales emergentes. Este conocimiento, considero, es imprescindible en un mundo cada vez más interconectado, no sólo para prevenir riesgos, sino también para integrar la tecnología de forma responsable al ejercicio profesional y garantizar la debida diligencia.

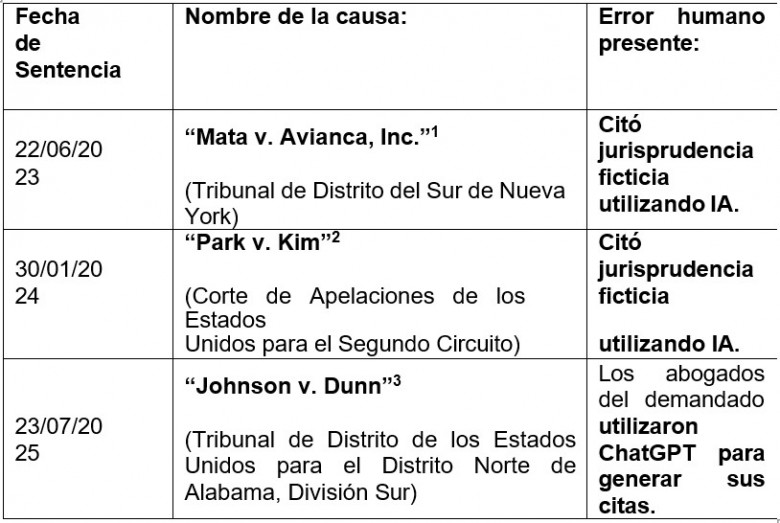

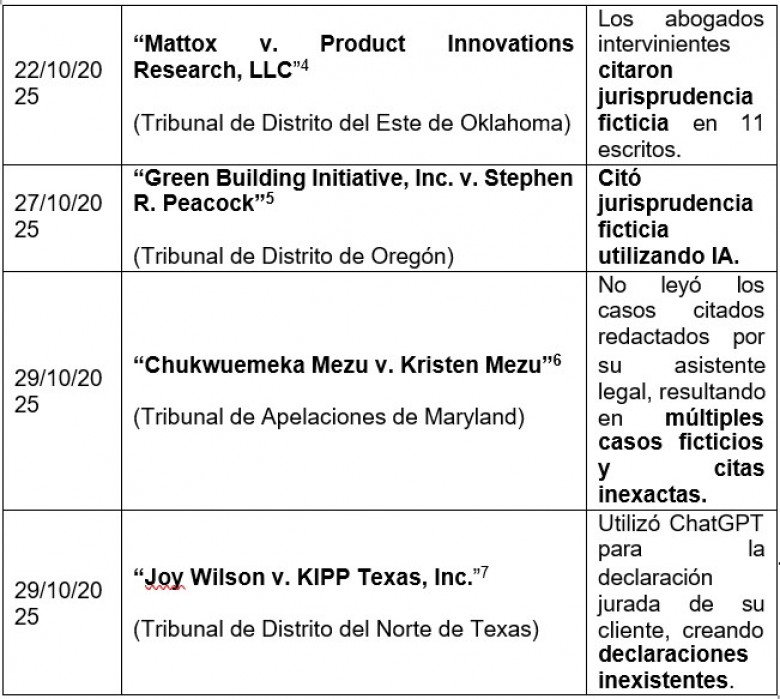

A continuación, con el propósito de reforzar la tesis de que el error no es tecnológico sino humano, se incluyen dos tablas que recopilan algunos de los casos judiciales hasta el momento en los Estados Unidos y en la Argentina, donde se utilizó inteligencia artificial de forma errónea.

a. Jurisprudencia en Estados Unidos:

Como simplifico en la tabla precedente, en todos los casos la confianza depositada en la inteligencia artificial, derivó en la cita de jurisprudencia y/o información inexistente dejando en evidencia que los abogados no revisaron de forma exhaustiva sus escritos. Veremos a continuación, que en nuestro país sucede lo mismo.

b. Jurisprudencia en Argentina:

Analizando la jurisprudencia citada, vemos que en el año 2025 aumentaron considerablemente los casos relacionados al uso inadecuado de inteligencia artificial, pero además, podemos ver una constante: los errores no provienen de la inteligencia artificial en sí, sino del uso sin control que los profesionales hacen de ella. Las herramientas generativas no actúan de forma autónoma en los procesos judiciales, sino que es el operador jurídico quien decide hacer uso de ellas, integrarlas a su flujo de trabajo, confiar en su resultado y, en última instancia, firmar bajo su responsabilidad.

Los casos mencionados confirman que la omisión de verificar los fallos e información citada constituye una falta de diligencia que responsabiliza al profesional. Se trata, por tanto, de errores humanos y no técnicos.

Así, la jurisprudencia demuestra una verdad incómoda pero necesaria: el riesgo no está en la tecnología, sino en cómo se la utiliza. A partir de esta premisa, desarrollaré un principio originado en el mundo de la ciberseguridad, pero útil y cada vez más necesario en el ámbito jurídico: “Don´t Trust, Verify” (no confíes, verifica).

III. El principio ´Don´t Trust, Verify´: Su origen y utilidad para el Derecho.

A los efectos de una mejor comprensión de este concepto, desarrollaré el apartado en dos partes: primero, se analizará cómo este principio se aplica en el mundo de la ciberseguridad; y segundo, su utilidad en el ámbito del Derecho.

El surgimiento y la adopción del principio ´Don’t Trust, Verify´ o, en su formulación más estricta, ´Never Trust, Always Verify´ (nunca confíes, siempre verifica)13, en el campo de la ciberseguridad representa una revolución paradigmática en la gestión del riesgo digital. Nacida de la necesidad de proteger sistemas informáticos complejos contra amenazas internas y externas, ofrece un marco de prudencia y responsabilidad directamente aplicable al ejercicio

a. Origen tecnológico: El modelo ´Zero Trust´ (Confianza Cero).

El principio ´Don’t Trust, Verify´ se consolida dentro del modelo de ciberseguridad conocido como ´Zero Trust´ (confianza cero)14. Este modelo surge en el año 2010 gracias a John Kindervag1516, como respuesta a la insuficiencia del enfoque tradicional de seguridad de ese momento, basado en el concepto de "castillo y foso" (castle-and-moat). En ese modelo, una vez que un usuario o dispositivo superaba la barrera externa (el firewall o "perímetro"), se le otorgaba confianza implícita y acceso libre a los recursos internos de la red17. En otras palabras, la dificultad recaía en poder ingresar a la red, pero una vez superado los controles impuestos la persona podía moverse libremente por el sistema accediendo a donde quisiera.

Sin embargo, con los avances de la tecnología, como la expansión de la computación en la nube, el trabajo remoto y la complejidad de las redes modernas, se hizo evidente que esa forma de proteger los sistemas e información no era fiable y se necesitaba un enfoque de verificación más intensivo. La principal vulnerabilidad del modelo tradicional residía en que, una vez violado el perímetro (a menudo mediante credenciales robadas), los atacantes podían moverse sin control dentro de la red, explotando esa confianza implícita.18 En otras palabras, el enfoque tradicional de la ciberseguridad se basa en barreras —cortafuegos— que controlan el tráfico entrante y saliente de una red. La confianza cero, en cambio, parte de la premisa de no tener barreras19.

El modelo ´Zero Trust´ elimina la confianza implícita por defecto. Su premisa fundamental es que ningún usuario, dispositivo, ni conexión es fiable por defecto, ya sea que se encuentre dentro o fuera del perímetro de la red20. Este enfoque asume la violación de los sistemas (assume breach) como una posibilidad constante21. Para eso, cada solicitud de acceso a un recurso, sin importar su origen, debe ser verificada y autenticada continuamente en tiempo real22.

El modelo exige la verificación continua de la identidad del usuario y del dispositivo, sus privilegios de acceso y el estado de la conexión. Se aplica el principio del privilegio mínimo, concediendo solo el nivel de permiso estrictamente necesario para completar una tarea. Esta supervisión constante reduce la superficie de ataque y limita la capacidad de los ciberdelincuentes para propagarse, minimizando el daño en caso de una brecha de seguridad23.

En esencia, ´Zero Trust´ (confianza cero) y su máxima ´Don’t Trust, Verify´ (No confíes, verifica) no promueven una desconfianza generalizada, sino la evolución de la confianza implícita hacia una cultura de comprobación constante y verificada.

b. Aplicación al Derecho: La diligencia profesional ante el avance de la inteligencia artificial generativa.

La lógica de la "confianza cero" es altamente aplicable para mitigar el riesgo de error humano en el ejercicio profesional del Derecho, especialmente cuando se integra la inteligencia artificial generativa en las tareas diarias para la redacción de escritos o la emisión de dictámenes.

La principal amenaza del uso de IA no es la intención maliciosa, sino el fenómeno de las "alucinaciones”, las cuales son resultados incorrectos, engañosos, sin sentido o que simplemente fabrican información (incluyendo citas o referencias a leyes inexistentes) sin basarse en los datos de entrenamiento24. Estos errores pueden ser causados por datos de entrenamiento incompletos, sesgos, o la incapacidad del modelo para fundamentar correctamente el conocimiento del mundo real25. Si un modelo de inteligencia artificial, incluso en las mejores circunstancias, puede generar consecuencias no deseadas e información inexacta, el abogado debe adoptar el mismo escepticismo fundamental que el modelo de confianza cero.

Trasladar la lógica del ´Don’t Trust, Verify´ al ámbito jurídico implica que el abogado debe asumir que la información generada por la inteligencia artificial es potencialmente falsa o inexacta, hasta que compruebe su veracidad en otra fuente -por ejemplo, consultando la existencia de un fallo en los buscadores de jurisprudencia de la Corte-.

Esta práctica constituye un nuevo estándar de diligencia profesional y ética, indispensable al incorporar contenido de inteligencia artificial generativa a documentos legales formales. El profesional del Derecho está obligado a verificar la exactitud y relevancia de la información antes de incorporarla.

Don’t Trust, Verify funciona como un análogo moderno del deber de verificación de fuentes. Si en ciberseguridad la supervisión humana es la última línea de defensa para validar y corregir la información generada por la IA, en el ámbito legal, esta supervisión se convierte en un mandato ético para asegurar la calidad y la veracidad del trabajo.

En conclusión, así como la ciberseguridad ha evolucionado de la confianza implícita en el perímetro a la confianza verificada en cada acceso, el Derecho debe realizar una transición similar. El principio Don’t Trust, Verify se reinterpreta entonces como un principio de precaución, verificación rigurosa y responsabilidad profesional, demostrando que la inteligencia artificial es un asistente valioso, pero su output siempre está sujeto a la validación experta del abogado.

IV. Conclusiones.

La inteligencia artificial dejó de ser una promesa del futuro para convertirse en una herramienta cotidiana que está redefiniendo la práctica jurídica. Sin embargo, su verdadero valor no reside únicamente en su potencial tecnológico, sino en la forma en que los profesionales del derecho decidan incorporarla en su trabajo diario. Con este artículo busqué generar conciencia sobre la importancia de un uso ético, crítico y responsable de la inteligencia artificial en el ámbito legal.

Considero que la educación es el punto de partida de todo cambio sostenible. A través de la formación continua y la alfabetización digital podremos garantizar que los abogados comprendan tanto las ventajas como las limitaciones de estas herramientas. En este sentido, tanto el Poder Judicial como los Colegios de Abogados tienen la oportunidad, las herramientas y la llegada para liderar este proceso de concientización mediante, por ejemplo, talleres, cursos, campañas en redes y espacios de reflexión que promuevan las buenas prácticas tecnológicas.

A mi modo de ver, el desafío no es tecnológico sino humano. Herramientas como ChatGPT pueden ayudar a optimizar procesos, buscar fallos y mejorar la redacción de un escrito, pero nunca reemplazarán el juicio profesional, la empatía y la responsabilidad que sustentan el trabajo jurídico. La supervisión humana sigue siendo esencial para garantizar precisión, prevenir sesgos y resguardar la confianza pública en el sistema judicial.

La verdadera innovación legal no está en usar inteligencia artificial, sino en cómo se la integra estratégicamente para potenciar la labor jurídica. Como expresé en un artículo de mi autoría llamado “ChatGPT vs. Grok: El veredicto de la IA para profesionales del derecho”26, la inteligencia artificial no es más que ceros y unos siguiendo una serie de patrones que se le indicaron. Lo verdaderamente transformador es el criterio, la ética y la visión de quien decide cómo y para qué usarlos. Porque el futuro del derecho no será escrito por las máquinas, sino por los profesionales que aprendan a convertir la tecnología en una extensión de su pensamiento crítico y su compromiso con la justicia.

Bibliografía unificada:

ACEVEDO GERARDO GABRIEL C/ CACERES MARECO WILLIAN ARSENIO Y AGROSALTA COOPERATIVA DE SEGUROS LIMITADA S/ DAÑOS Y PERJ.AUTOM. C/LES. O MUERTE (EXC.ESTADO), MO-19435-

2020, Cámara de Apelación en lo Civil y Comercial de Morón, Sala I, septiembre de 2025. Recuperado el 2 de noviembre de https://www.scba.gov.ar/includes/descarga.asp?id=57443&n=Ver+sentencia+(c ausa+19.435).pdf&utm_source=chatgpt.com

BARRERA, V.E. C/ CUEVAS, B.R.Y. S/ ACCIONES POSESORIAS/REALES – REIVINDICACIÓN – TRAM. ORAL, Expte.

12829614, Cámara de Apelación en lo Civil y Comercial de Córdoba, Sala 5ª, septiembre de 2025. Recuperado el 1 de noviembre de https://www.diariojudicial.com/uploads/0000059702-original.pdf

Candia, A. (2025, 31 de octubre). ChatGPT vs. Grok: El veredicto de la IA para profesionales del derecho. [Publicación en LinkedIn]. LinkedIn. Recuperado de https://www.linkedin.com/posts/candialexis_el-veredicto-de-la- ia-para-profesionales-activity-7316463757814054913- uWuJ?utm_source=share&utm_medium=member_desktop&rcm=ACoAADV4fn wBi11CNKHnPQnFGRBds8DL8Ai9CC0

Cloudflare Inc. (s. f.). Zero Trust security | What is a Zero Trust network? Recuperado el 2 de noviembre de 2025, de https://www.cloudflare.com/learning/security/glossary/what-is-zero-trust/

GIACOMINO, C.A. Y OTROS C/ MONSERRAT, F.D. Y OTROS S/

DAÑOS Y PERJUICIOS, CUIJ 21-11893083-2, Cámara de Apelación en lo Civil y Comercial de Rosario, Sala II, agosto de 2025. Recuperado el 1 de noviembre de https://sipla.ip.mpg.de/fileadmin/Files/Files/Giacomino_c._Monserrat.pdf

Google Cloud. (s. f.). ¿Qué son las alucinaciones de la IA? Recuperado el 2 de noviembre de 2025, de https://cloud.google.com/discover/what-are-ai- hallucinations?hl=es-419Green Building Initiative, Inc. v. Stephen R. Peacock & Green Globe Limited, No. 3:24-cv-00298-SI (D. Or. Oct. 27, 2025). Recuperado el 1 de noviembre de https://websitedc.s3.amazonaws.com/documents/Green_Building_Initiative_v._ Stephen_Peacock_USA_27_October_2025.pdf

IBM. (s. f.). ¿Qué son las alucinaciones de IA? Recuperado el 2 de noviembre de 2025, de https://www.ibm.com/es-es/think/topics/ai-hallucinations

IBM. (s. f.). Zero trust. IBM Think. Recuperado el 2 de noviembre de 2025, de https://www.ibm.com/es-es/think/topics/zero-trust

Illumio. (s. f.). John Kindervag shares Zero Trust’s origin story. Recuperado el 2 de noviembre de 2025, de https://www.illumio.com/es- mx/blog/john-kindervag-shares-zero-trusts-origin-story

Johnson v. Dunn., No.: 2:21-cv-1701-AMM (N.D. Ala July 23, 2025). Recuperado el 5 de noviembre de 2025, de https://docs.justia.com/cases/federal/district- courts/alabama/alndce/2:2021cv01701/179677/204

Kerman, A. (2020, 28 de octubre). Zero trust cybersecurity: ‘Never trust, always verify’. National Institute of Standards and Technology (NIST). Recuperado el 2 de noviembre de 2025, de https://www.nist.gov/blogs/taking- measure/zero-trust-cybersecurity-never-trust-always-verify

M.J.L. C/ PEUGEOT CITROEN ARGENTINA S.A. Y OTRA S/

SUMARISIMO, RO-12819-C-0000, Cámara de Apelaciones en lo Civil, Comercial, Familia y Minería de General Roca, Sala I, septiembre de 2025. Recuperado el 5 de noviembre de https://www.saij.gob.ar/abogados-inventaron- fallos-ia-podran-cobrar-honorarios-nv48341-2025-09-18/123456789-0abc-143- 84ti-lpssedadevon?

Mata v. Avianca Inc., No. 22-cv-01461 (PKC) (S.D.N.Y. Jun. 22, 2023).

Recuperado el 1 de noviembre de 2025, de https://caselaw.findlaw.com/court/us- dis-crt-sd-new-yor/2335142.html

Mattox v. Product Innovations Research, LLC., No. 6:24-cv-235-JAR (E.D. Okla Oct. 22, 2025). Recuperado el 1 de noviembre de https://websitedc.s3.amazonaws.com/documents/Mattox_v._Product_Innovatio ns_Research_USA_22_October_2025.pdf

Mezu v. Mezu, No. 361, September Term, 2025 (Md. Ct. Spec. App. Oct. 29, 2025). Recuperado el 1 de noviembre de https://www.mdcourts.gov/data/opinions/cosa/2025/0361s25.pdf

Park v. Dunn., No. 22-2057 (2d Cir. Jan. 30, 2024). Recuperado el 5 de noviembre de https://law.justia.com/cases/federal/appellate-courts/ca2/22- 2057/22-2057-2024-01-30.html

PROVINCIA DEL CHUBUT C/ P.R.A., Carp. OFIJU NIC n.º 6209 – Leg.

Fiscal n.º 59560, 2025, Cámara en lo Penal de la Circunscripción Judicial del Noroeste del Chubut, 15 de octubre). Recuperado el 1 de noviembre de https://websitedc.s3.amazonaws.com/documents/wp- 1760559941807.pdf?utm_source=chatgpt.com

Wilson v. KIPP Texas Inc., No. 3:24-cv‐02578-K (N.D. Tex. Oct. 29, 2025). Recuperado el 1 de noviembre de https://law.justia.com/cases/federal/district- courts/texas/txndce/3:2024cv02578/395701/53/

Más contenido jurídico en elDial.com

Citas

(*) Abogado por la Universidad Nacional del Centro de la Provincia de Buenos Aires (UNICEN), posgrado en Compliance Integral y diplomado en Compliance enfocado en la Ciberseguridad, ambos por Governance School de la Universidad del Museo Social Argentino (UMSA). Analista de riesgo digital e impulsor de una cultura digital responsable. Speaker en la ONG Bitcoin Argentina. LinkedIn: Alexis Candia.

1 Mata v. Avianca Inc., No. 22-cv-01461 (PKC) (S.D.N.Y. Jun. 22, 2023). Recuperado el 1 de noviembre de 2025, de https://caselaw.findlaw.com/court/us-dis-crt-sd-new-yor/2335142.html

2 Park v. Dunn., No. 22-2057 (2d Cir. Jan. 30, 2024). Recuperado el 5 de noviembre de https://law.justia.com/cases/federal/appellate-courts/ca2/22-2057/22-2057-2024-01-30.html

3 Johnson v. Dunn., No.: 2:21-cv-1701-AMM (N.D. Ala July 23, 2025). Recuperado el 5 de noviembre de 2025, de https://docs.justia.com/cases/federal/district- courts/alabama/alndce/2:2021cv01701/179677/204

4 Mattox v. Product Innovations Research, LLC., No. 6:24-cv-235-JAR (E.D. Okla Oct. 22, 2025). Recuperado el 1 de noviembre de https://websitedc.s3.amazonaws.com/documents/Mattox_v._Product_Innovations_Research_U SA_22_October_2025.pdf

5 Green Building Initiative, Inc. v. Stephen R. Peacock & Green Globe Limited, No. 3:24-cv- 00298-SI (D. Or. Oct. 27, 2025). Recuperado el 1 de noviembre de https://websitedc.s3.amazonaws.com/documents/Green_Building_Initiative_v._Stephen_Peaco ck_USA_27_October_2025.pdf

6 Mezu v. Mezu, No. 361, September Term, 2025 (Md. Ct. Spec. App. Oct. 29, 2025). Recuperado

el 1 de noviembre de https://www.mdcourts.gov/data/opinions/cosa/2025/0361s25.pdf

7 Wilson v. KIPP Texas Inc., No. 3:24-cv‐02578-K (N.D. Tex. Oct. 29, 2025). Recuperado el 1 de noviembre de https://law.justia.com/cases/federal/district- courts/texas/txndce/3:2024cv02578/395701/53/

8 Expte. N° 21-11893083-2 - “G, C A y otros c/ M F D y otros s/ daños y perjuicios” –

CÁMARA DE APELACIÓN EN LO CIVIL Y COMERCIAL DE ROSARIO (Santa Fe) - Sala II -

//08/2025 (elDial.com - AAEAD8)

9 Expte. N° 12829614 - “B, V E C/ C, B R Y - acciones posesorias/reales - reivindicación -

tram.oral” - CÁMARA DE APELACIÓN CIVIL Y COMERCIAL 5ª DE CÓRDOBA (Córdoba) –

05/09/2025 (elDial.com - AAEBB1)

10 Expte. N° MO-19435-2020 - "A G G C/ C M W A y Agrosalta cooperativa de seguros limitada s/ daños y perj. autom. c/les. o muerte (exc. Estado)" – CÁMARA DE APELACIÓN EN LO CIVIL Y COMERCIAL DE MORÓN (Buenos Aires) - SALA I - 15/09/2025 (elDial.com - AAEB70)

11 Expte. N° RO-12819-C-0000 – “M.J.L. C/ Peugeot Citroen Argentina S A y otra s/ sumarísimo” - CÁMARA APELACIONES EN LO CIVIL, COMERCIAL, FAMILIA Y MINERÍA

DE GENERAL ROCA (Río Negro) - 18/09/2025 (elDial.com - AAEB9B)

12 Carpeta Judicial nro. 6209 - “PROVINCIA DEL CHUBUT c/ P.R.A.” (Legajo Fiscal N°

59560) - CÁMARA EN LO PENAL DE LA CIRCUNSCRIPCIÓN JUDICIAL DE ESQUEL

(Chubut) - 15/10/2025 (elDial.com - AAEC4F)

13 IBM. (s. f.). Zero trust. IBM Think. Recuperado el 2 de noviembre de 2025, de https://wwgw.ibm.com/es-es/think/topics/zero-trust

profesional del Derecho, especialmente frente a la inteligencia artificial generativa.

14 Kerman, A. (2020, 28 de octubre). Zero trust cybersecurity: ‘Never trust, always verify’. National Institute of Standards and Technology (NIST). Recuperado el 2 de noviembre de 2025, de https://www.nist.gov/blogs/taking-measure/zero-trust-cybersecurity-never-trust-always-verify

15 Kerman, A. (2020, 28 de octubre). Zero trust cybersecurity: ‘Never trust, always verify’. National Institute of Standards and Technology (NIST). Recuperado el 5 de noviembre de 2025, de https://www.nist.gov/blogs/taking-measure/zero-trust-cybersecurity-never-trust-always-verify

16 Illumio. (s. f.). John Kindervag shares Zero Trust’s origin story. Recuperado el 2 de noviembre de 2025, de https://www.illumio.com/es-mx/blog/john-kindervag-shares-zero- trusts-origin-story

17 Cloudflare Inc. (s. f.). Zero Trust security | What is a Zero Trust network? Recuperado el 2 de noviembre de 2025, de https://www.cloudflare.com/learning/security/glossary/what-is-zero-trust/

18 Kerman, A. (2020, 28 de octubre). Zero trust cybersecurity: ‘Never trust, always verify’. National Institute of Standards and Technology (NIST). Recuperado el 2 de noviembre de 2025, de https://www.nist.gov/blogs/taking-measure/zero-trust-cybersecurity-never-trust-always-verify

19 Kerman, A. (2020, 28 de octubre). Zero trust cybersecurity: ‘Never trust, always verify’. National Institute of Standards and Technology (NIST). Recuperado el 2 de noviembre de 2025, de https://www.nist.gov/blogs/taking-measure/zero-trust-cybersecurity-never-trust-always-verify

20 Cloudflare Inc. (s. f.). Zero Trust security | What is a Zero Trust network? Recuperado el 2 de noviembre de 2025, de https://www.cloudflare.com/learning/security/glossary/what-is-zero-trust/

21 IBM. (s. f.). Zero trust. IBM Think. Recuperado el 2 de noviembre de 2025, de https://www.ibm.com/es-es/think/topics/zero-trust

22 Kerman, A. (2020, 28 de octubre). Zero trust cybersecurity: ‘Never trust, always verify’. National Institute of Standards and Technology (NIST). Recuperado el 2 de noviembre de 2025, de https://www.nist.gov/blogs/taking-measure/zero-trust-cybersecurity-never-trust-always-verify 23 Cloudflare Inc. (s. f.). Zero Trust security | What is a Zero Trust network? Recuperado el 2 de noviembre de 2025, de https://www.cloudflare.com/learning/security/glossary/what-is-zero-trust/

24 IBM. (s. f.). ¿Qué son las alucinaciones de IA? Recuperado el 2 de noviembre de 2025, de https://www.ibm.com/es-es/think/topics/ai-hallucinations

25 Google Cloud. (s. f.). ¿Qué son las alucinaciones de la IA? Recuperado el 2 de noviembre de 2025, de https://cloud.google.com/discover/what-are-ai-hallucinations?hl=es-419

26 Candia, A. (2025, 31 de octubre). ChatGPT vs. Grok: El veredicto de la IA para profesionales del derecho. [Publicación en LinkedIn]. LinkedIn. Recuperado de https://www.linkedin.com/posts/candialexis_el-veredicto-de-la-ia-para-profesionales-activity- 7316463757814054913-

uWuJ?utm_source=share&utm_medium=member_desktop&rcm=ACoAADV4fnwBi11CNKHnP QnFGRBds8DL8Ai9CC0

Artículos

FRTB - FERRER REYES, TELLECHEA & BOUCHE

opinión

ver todosEstudio Garrido Abogados

Cassagne Abogados