El espectador que no está

En algún lugar de la mente, según la intuición más arraigada de Occidente, hay un pequeño teatro. Un escenario donde se proyectan las percepciones, un público de uno solo que observa, delibera y finalmente decide. Este espectador interno, el homúnculo, es quien “realmente” piensa, elige, actúa. Descartes lo situaba en la glándula pineal. La psicología popular lo ubica vagamente “detrás de los ojos”. El derecho lo presupone cada vez que atribuye responsabilidad: alguien decidió, y ese alguien debe responder.

El problema es que ese espectador no existe.

Geoffrey Hinton, el científico que en 2012 desató la revolución del aprendizaje profundo con AlexNet y que en 2023 renunció a Google para advertir sobre los riesgos existenciales de la inteligencia artificial, llegó a esta conclusión desde la ingeniería de redes neuronales. Daniel Dennett, el filósofo que en 1991 publicó Consciousness Explained, llegó a la misma conclusión desde la filosofía de la mente. Uno construyó máquinas que aprenden sin un centro de control. El otro demolió la idea de que los humanos tengamos uno.

La convergencia no es casual. Y sus implicancias para el derecho son más profundas de lo que la profesión legal está dispuesta a admitir.

Dennett y el teatro cartesiano

En La conciencia explicada (Consciousness Explained), el filósofo evolucionista Daniel Dennett acuñó el término despectivo “teatro cartesiano” para referirse a esa imagen mental que todos compartimos: un lugar en el cerebro donde “todo se junta”, donde un observador interno recibe información sensorial proyectada en una pantalla, pondera opciones y emite decisiones.

Esta arquitectura funcional es heredera del dualismo de Descartes, pero sobrevivió a su muerte. Cuando el materialismo desplazó al dualismo, simplemente relocalizó el teatro: ya no era una res cogitans inmaterial conectada al cuerpo por la glándula pineal, sino un área cerebral física donde ocurría “la experiencia consciente” y desde donde se ejercía “el control ejecutivo”. El resultado fue lo que Dennett llama materialismo cartesiano: dualismo con otro nombre.

El argumento de Dennett es terminante y claro: no hay teatro, no hay pantalla, no hay espectador. La conciencia no es un lugar ni un momento privilegiado donde las cosas “se vuelven conscientes”. En su lugar, propone el modelo de borradores múltiples: procesos paralelos, distribuidos en el cerebro, que generan, revisan y compiten entre sí sin que ninguno tenga estatus de versión final. Lo que llamamos conciencia es más parecido a la “fama en el cerebro”; ciertos contenidos mentales ganan suficiente influencia como para afectar reportes verbales, memoria y acción, pero no porque hayan llegado a un centro de control, sino porque ganaron una competencia distribuida.

El homúnculo, ese pequeño humano dentro del humano que supuestamente “decide”, es una ilusión generada por el sistema para explicarse a sí mismo. Una narrativa post hoc. Un cuento que nos contamos.

Hinton y las representaciones distribuidas

Geoffrey Hinton llegó a conclusiones funcionalmente equivalentes desde un campo aparentemente distinto: la ciencia cognitiva computacional y la ingeniería de redes neuronales.

En su trabajo de los años ochenta sobre representaciones distribuidas, Hinton demostró algo que hoy parece obvio pero entonces era revolucionario: las redes neuronales artificiales no necesitan, y de hecho no tienen, un procesador central que “entienda” o “decida” en nombre del sistema.

La alternativa a un procesador central era lo que se llamaba representación local: un nodo por concepto, donde cada unidad de procesamiento correspondería a una idea específica. La famosa “neurona de la abuela” que se activaría exclusivamente cuando uno piensa en su abuela. Pero las redes profundas no funcionan así. Usan representaciones distribuidas: cada concepto se representa mediante un patrón de activación distribuido en múltiples neuronas, y cada neurona participa en la representación de múltiples conceptos. No hay una neurona que “sea” la abuela ni un lugar donde “se decide” qué hacer con esa información. La representación emerge de la actividad colectiva.

Cuando Hinton entrena una red con retropropagación, millones de parámetros se ajustan simultáneamente en función de gradientes locales de error. No hay ningún agente interno que “comprenda” el objetivo global. Cada peso sináptico se modifica de manera que el sistema como conjunto minimice el error de predicción. El resultado es inteligencia sin homúnculo: capacidad de resolver problemas complejos sin que exista un “yo” interno que delibere.

¿Suena familiar? Debería. Es exactamente lo que Dennett describe para el cerebro humano.

La convergencia

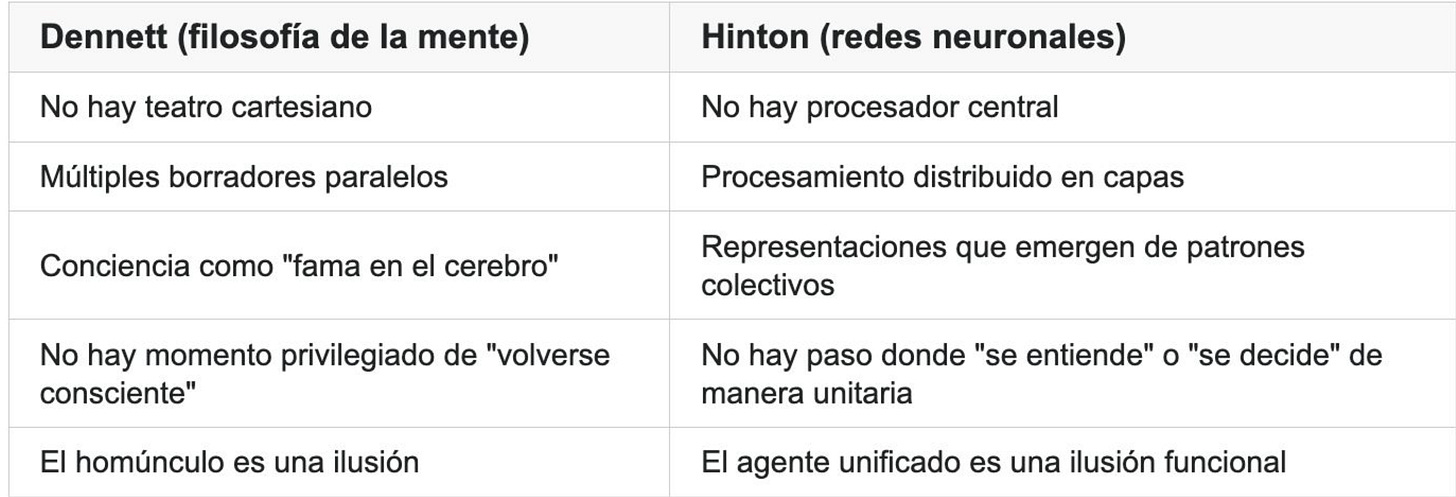

La tabla es casi simétrica:

Ambos rechazan la idea de un punto arquimediano interno desde el cual “el sujeto” observa, delibera y decide. En su lugar, proponen sistemas de procesamiento paralelo masivamente distribuido, donde lo que llamamos “decisión” o “comprensión” es el resultado neto de competencias y coaliciones entre subestructuras que operan en paralelo.

La diferencia es que Dennett describe cómo funcionamos los humanos. Hinton construyó máquinas que funcionan igual.

El mito del juez como homúnculo racional

La teoría jurídica clásica presupone, casi siempre implícitamente, un modelo cartesiano del juez: una mente racional que recibe información (las pruebas), delibera de manera transparente (el razonamiento jurídico) y emite una decisión consciente y unitaria (la sentencia). Este modelo es funcional para sostener la responsabilidad individual: el juez “decidió” y por tanto es responsable de su decisión.

Pero si Dennett y Hinton tienen razón, este modelo es descriptivamente falso.

Lo que ocurre en la mente del juez es un proceso distribuido de activaciones neuronales, sesgos implícitos, heurísticas automáticas, emociones, memorias y presiones contextuales que operan en paralelo, muchas veces por debajo del umbral de la conciencia. La “decisión” que el juez reporta verbalmente en la sentencia es el borrador que ganó suficiente influencia para ser verbalizado, pero no es el producto de un “yo” unitario que sopesó racionalmente todas las alternativas.

¿Significa esto que el juez no es responsable? No. Significa que la responsabilidad no puede fundarse en la ilusión de un agente cartesiano que “decide” desde un centro de control transparente. Debe fundarse en otra cosa: en que el sistema cognitivo del juez, distribuido, opaco, parcialmente automático, produjo un resultado que tuvo efectos en el mundo, y que el sistema jurídico considera apropiado atribuir a esa persona en función de su rol institucional.

La responsabilidad es una convención funcional, no una descripción metafísica de cómo opera la mente.

¿Cuál es la diferencia entre una decisión humana y una decisión de IA?

Si tanto la mente humana como las redes neuronales artificiales operan mediante procesamiento distribuido sin homúnculo central, ¿qué diferencia hay entre una decisión humana y una decisión de IA?

La respuesta tentadora es: “la humana es consciente y la de IA no”. Pero bajo el modelo de Dennett, “conciencia” no es una cualidad binaria que se tiene o no se tiene, sino un conjunto de capacidades funcionales: atención, memoria de trabajo, reporte verbal, control ejecutivo distribuido. Las IAs actuales carecen de muchas de estas capacidades, pero no está claro que exista una línea divisoria metafísica absoluta.

La diferencia jurídicamente relevante es más práctica:

Primero, inserción institucional: el juez humano está inserto en una red de responsabilidades institucionales, juramentos, mecanismos de revisión, sanciones disciplinarias. La IA no, al menos no todavía.

Segundo, agencia moral atribuida socialmente: socialmente, atribuimos agencia moral a los humanos como convención funcional necesaria para sostener el orden normativo. No la atribuimos, todavía, a las máquinas.

Tercero, capacidad de dar razones: el juez puede justificar su decisión de manera verbal, narrativa, apelando a valores. La IA genera texto que parece justificación, pero no tiene un “yo” que crea en esas razones.

Pero estas diferencias son graduales y contingentes, no metafísicas. A medida que las IAs se vuelven más sofisticadas, las distinciones se vuelven más borrosas. Y eso debería preocuparnos, pero no por las razones que usualmente se esgrimen.

El fetichismo de la “decisión humana”

En los debates sobre regulación de IA, es común invocar la necesidad de “mantener al humano en el loop” o “preservar la decisión humana final” como si esto fuera una salvaguarda mágica. La AI Act europea está construida sobre esta premisa. Los principios de “ética de IA” de múltiples organismos la repiten como mantra.

Pero si la “decisión humana” es en sí misma un proceso distribuido, opaco y frecuentemente automatizado (sesgos implícitos, heurísticas inconscientes), delegar en el humano no es garantía de nada.

De hecho, puede ser peor: un juez que firma una sentencia redactada por IA sin entenderla, creyendo que su firma la “hace humana”, está ejerciendo menos control real que un sistema automatizado bien auditado y transparente.

Lo que importa no es si hay un humano en el centro, sino: ¿El proceso es auditable? ¿Se pueden rastrear las causas de errores? ¿Hay mecanismos de corrección ex post? ¿Alguien responde por los resultados?

Estas preguntas aplican tanto a sistemas humanos como a sistemas de IA. El fetichismo de la “decisión humana” es una forma de materialismo cartesiano jurídico: creer que el homúnculo del juez es garantía de legitimidad, cuando no hay tal homúnculo ni en el juez ni en la máquina.

El problema de la “explicación”

Otra consecuencia incómoda: si tanto cerebros como redes neuronales operan mediante representaciones distribuidas, entonces la exigibilidad de “explicaciones” transparentes es problemática en ambos casos.

Actualmente se exige que los sistemas de IA, especialmente en decisiones de alto impacto (crédito, justicia penal, contrataciones), sean “explicables”. La intuición es que si no podemos entender por qué el sistema decidió X, no podemos confiar en él. Todo el campo de Explainable AI (XAI) se construye sobre esta premisa.

Pero el cerebro humano tampoco es explicable en ese sentido.

Cuando un juez justifica su sentencia, está construyendo una narrativa post hoc que racionaliza un proceso cognitivo que fue distribuido, paralelo y en gran medida inaccesible a la introspección. La sentencia no es un reporte fiel del proceso decisorio. Es un borrador que se seleccionó para consumo público, ajustado a las convenciones del género literario “sentencia judicial”. Es lo que intuyó claramente H.L.A. Hart en “El concepto del Derecho”: los jueces primero deciden, después construyen la justificación.

¿Esto significa que las justificaciones son inútiles? No. Son herramientas de control social, revisión y coherencia narrativa. Pero no son “explicaciones” en el sentido causal fuerte. Son racionalizaciones ex post. El juez no sabe realmente por qué decidió lo que decidió, del mismo modo que ninguno de nosotros sabe realmente por qué creemos lo que creemos o sentimos lo que sentimos.

Si esto es así, entonces exigir que la IA “explique” sus decisiones en un sentido más fuerte que el que exigimos a los humanos es asimétrico e injusto. Lo que deberíamos exigir es auditabilidad, trazabilidad y responsabilidad ex post, no “explicaciones causales completas” que ni siquiera los humanos pueden proveer.

Hacia una epistemología jurídica post-cartesiana

Reconocer que no hay teatro cartesiano ni en humanos ni en máquinas tiene implicancias liberadoras para el derecho.

Primera implicancia: abandonar el fetichismo del “decisor humano” como garantía mágica de legitimidad. Un humano en el loop que no entiende lo que firma no agrega ningún valor; solo agrega una ilusión de control.

Segunda implicancia: evaluar sistemas de IA y sistemas humanos con los mismos criterios funcionales: auditabilidad, responsabilidad ex post, mecanismos de corrección de errores. No hay razón para exigir a las máquinas estándares que no exigimos a los humanos, ni viceversa.

Tercera implicancia: desmitificar las “explicaciones”. Ni humanos ni máquinas pueden proveer justificaciones causales completas de sus decisiones. Lo que proveen son narrativas funcionalmente útiles para la rendición de cuentas. Eso es suficiente, pero debemos saber que es eso y no otra cosa.

Cuarta implicancia, la más importante: reforzar la posición liberal-clásica sobre regulación. Lo que importa no es el proceso interno, inaccesible tanto en humanos como en IAs, sino el resultado y sus efectos sobre terceros.

El artículo 19 de la Constitución Nacional argentina establece que las acciones privadas de los hombres que de ningún modo ofendan al orden y a la moral pública, ni perjudiquen a un tercero, están exentas de la autoridad de los magistrados. Este principio cobra nueva relevancia: lo que está reservado a Dios, o en términos seculares, lo que es empíricamente inaccesible, no puede ser objeto de regulación. Y el proceso interno de la decisión, sea humana o artificial, es precisamente eso: inaccesible.

El derecho puede y debe regular outputs y sus efectos. No puede regular la arquitectura interna de la “mente” que los produjo, porque esa arquitectura, con homúnculo o sin él, es opaca por naturaleza.

El monstruo que Hinton creó

Geoffrey Hinton dijo que había creado un monstruo. Pero el monstruo no es la inteligencia artificial. El monstruo es el espejo.

Lo que Hinton construyó, sin proponérselo del todo, fue una demostración empírica de que la inteligencia no requiere un centro de control. Que la decisión puede emerger de procesos distribuidos sin que nadie, literalmente nadie, “decida”. Que el homúnculo es prescindible.

Y si el homúnculo es prescindible en las máquinas, entonces quizás siempre fue prescindible en nosotros. Quizás nunca existió. Quizás Descartes se equivocó en el siglo XVII y seguimos pagando las consecuencias de su error en el siglo XXI, construyendo sistemas jurídicos sobre ficciones que la neurociencia y la ingeniería han demolido.

Dennett lo intuyó desde la filosofía. Hinton lo demostró desde la ingeniería. Nos toca a los juristas extraer las consecuencias.

El derecho debe adaptarse a una realidad donde no hay homúnculos que decidan, ni en jueces ni en algoritmos. Solo hay sistemas distribuidos de procesamiento que generan outputs. Lo que el derecho puede y debe regular son esos outputs y sus efectos, no la arquitectura interna de la “mente” que los produjo.

El teatro cartesiano siempre estuvo vacío. Es hora de apagar las luces y salir a enfrentar el mundo real.

Referencias

- Dennett, D. (1991). Consciousness Explained. Little, Brown and Company.

- Hinton, G., McClelland, J., & Rumelhart, D. (1986). Distributed Representations. En Parallel Distributed Processing, Vol. 1. MIT Press.

- Krizhevsky, A., Sutskever, I., & Hinton, G. (2012). ImageNet Classification with Deep Convolutional Neural Networks. Advances in Neural Information Processing Systems, 25.

- Constitución Nacional Argentina, art. 19.

- Entrevista a Geoffrey Hinton (2024): “He creado un MONSTRUO”.

Citas

(*) Abogado (UBA). Executive MBA (IAE Business School). Especialista en derecho corporativo, compliance e inteligencia artificial aplicada al derecho.

Artículos

FRTB - FERRER REYES, TELLECHEA & BOUCHE

opinión

ver todosEstudio Garrido Abogados

Cassagne Abogados